Crea videos realistas a partir de texto con Sora, la opción de OpenAI creador de ChatGPT

OpenAI, la reconocida organización de investigación en inteligencia artificial detrás de ChatGPT, ha marcado un nuevo hito en la evolución de la tecnología con el lanzamiento de Sora, una herramienta capaz de generar videos a partir de descripciones textuales.

Este avance no solo amplía los horizontes de la creación de contenido digital, sino que también ofrece perspectivas fascinantes sobre cómo la interacción entre lenguaje y visuales puede transformar la manera en que se utiliza la inteligencia artificial en la actualidad.

Sora de OpenAI es un nuevo modelo que, aunque aún está en fase de pruebas, ya puede crear videos de hasta un minuto. La empresa dirigida por Sam Altman, dice que Sora puede hacer videos que se ven muy reales y sigue exactamente lo que los usuarios piden, sin perder calidad en las imágenes.

Sora, la IA capaz de generar videos

Sora opera utilizando un principio muy similar al de los generadores que convierten texto en imagen. Esto significa que los usuarios pueden dar instrucciones o “prompts” muy detallados sobre lo que quieren ver en el video.

Estas indicaciones pueden ser tan específicas como el usuario desee, permitiéndole incluir detalles precisos sobre el movimiento de la cámara, el paisaje, la vestimenta de las personas y otros elementos que deseen incorporar en la escena.

Esto ofrece una gran libertad creativa, ya que la herramienta se adapta a las especificaciones dadas para generar un video que corresponda lo más fielmente posible a la visión del usuario.

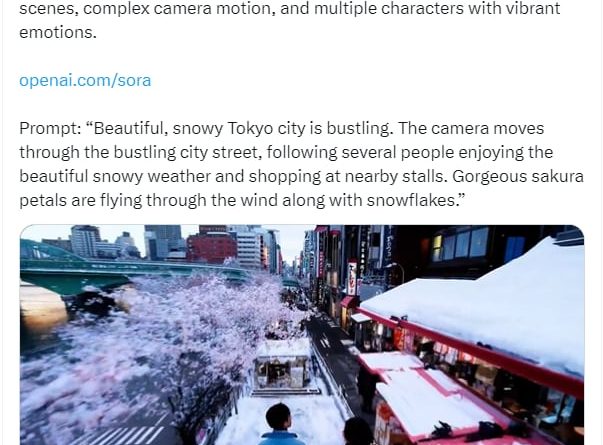

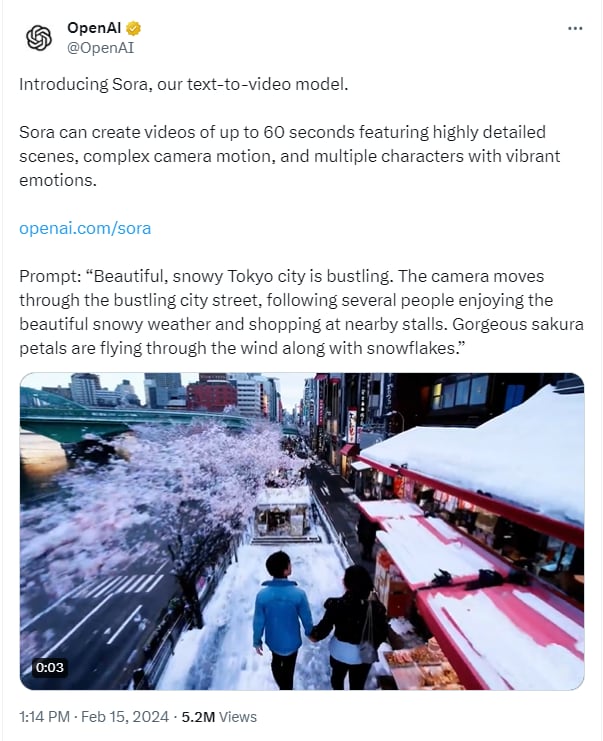

OpenAI compartió varios ejemplos de videos y de prompts, uno de ellos fue:

“La hermosa ciudad de Tokio, nevada, está llena de vida. La cámara se mueve por la concurrida calle de la ciudad, siguiendo a varias personas que disfrutan del hermoso clima nevado y compran en puestos cercanos. Hermosos pétalos de sakura vuelan con el viento junto con los copos de nieve.”

Disponibilidad actual de Sora

Actualmente, Sora está siendo utilizada de manera exclusiva por un grupo selecto de personas que forman parte del “equipo rojo” de OpenAI, con el objetivo principal de identificar posibles fallos, daños o riesgos en la herramienta.

El “equipo rojo” es un grupo especializado cuya función principal es evaluar y probar sistemas, software o aplicaciones para identificar vulnerabilidades, fallos o riesgos potenciales. Su trabajo consiste en pensar y actuar como adversarios potenciales, emulando los métodos y tácticas que un atacante real podría utilizar.

Además, OpenAI ha extendido el acceso a Sora a una pequeña comunidad de artistas visuales, diseñadores y cineastas para recabar sus opiniones y así mejorar y adaptar el modelo, haciéndolo más útil para aquellos en el ámbito creativo.

La compañía ha decidido compartir desde temprano los desarrollos y avances de su investigación para abrir un canal de retroalimentación con personas fuera de OpenAI, permitiendo así entender mejor cómo se pueden potenciar las capacidades de la inteligencia artificial para beneficio y avance en diversas áreas, a la vez que ofrece al público un vistazo a lo que las futuras tecnologías de IA podrán realizar.

OpenAI ha señalado que los videos que compartieron en el blog para anunciar Sora no han recibido ningún tipo de edición.

Al tener esto en cuenta, parece ser que la herramienta tiene un gran potencial, aunque es necesario experimentar con ella personalmente para evaluar sus verdaderas capacidades.

No obstante, la empresa también ha advertido que, como ocurre con cualquier otra herramienta de inteligencia artificial, Sora presenta sus propias limitaciones y desafíos.

Por ejemplo, podría experimentar problemas para representar de manera precisa la física en escenas complejas o fallar al identificar relaciones específicas de causa y efecto entre elementos de un video.

Sin embargo, habrá que esperar un poco más para poder tener acceso y probar este nuevo modelo directamente.

Fuente: InfoBae